“AI的尽头是光伏和储能”,相信很多人对这句话并不陌生。这句话非常形象地说明了AI对电力的高依赖和高消耗,言简意赅,在业界广为流传。

近两年以大模型为代表的人工智能非常火,引发了大模型投资热,企业纷纷投入巨资开始训练大模型和部署各种人工智能应用。然而,不少企业突然发现电出问题了,要么数据中心的电力不够,要么机房温度降不下来,或者用电成本太高账单吓人,严重的甚至直接影响数据中心正常运营,波及企业的数字化化转型战略的落实。为了破解这些难题,不少企业走上绿色数据中心的构建之路。

大模型的背后是对电力的高消耗

2022年年底,ChatGPT一炮走红。ChatGPT表现出来的强大的内容生成能力让人惊讶,但很多人不了解的是,这些能力是建立在大量数据的训练之上,需要消耗大量的电力。

斯坦福人工智能研究所发布的《2023年人工智能指数报告》显示,1750亿参数的GPT-3在训练阶段的耗电量高达1287兆瓦时。随着模型参数的不断增加以及模型从单模态向多模态发展,耗电量还将进一步提升。

大模型不只是在训练阶段费电,推理阶段同样也相当费电。根据专家对ChatGPT的研究,每当ChatGPT试图响应一次提问,它需要消耗2.9瓦时的电量。ChatGPT平均每天需要处理约2亿个来自用户的对话请求,这意味着它单日消耗的电量就要超过564兆瓦时,相当于1.7万个美国家庭一天的用电量。

ChatGPT是通用大模型的一个代表,其他大模型的耗电情况大体类似。随着大模型的流行,AI工作负载功耗占比正在快速提升。根据施耐德电气的一份关于2024数据中心行业的研究报告,AI类工作负载功耗2023 年只占到8%,而到 2028 年会占15%-20%,总能耗预计会到 15GW,相当于十三峡水电站的总装机容量 22.5GW的70%。

通用大模型之所以费电,一个重要原因是它的训练和推理都需要大量GPU,今天GPU集群越来越大,万卡甚至10万卡也不稀奇,而GPU随着性能的不断提升功耗会不断上升,正在从目前的350瓦向1000瓦迈进,英伟达新发布的最新GPU GB200已经突破了1000瓦。当然,不只是GPU,CPU的功耗也在上升,正在突破500瓦。

CPU、GPU功耗的不断上升迫使企业越来越关注AI架构的优化,要把数千甚至上万张CPU、GPU卡互联,让它们高效访问所需要的数据,完成工作,对系统架构设计提出了很高的要求。

“一个设计良好的AI架构的确能大大提高整个设备的能效,这些年戴尔科技一直在做的事情。”戴尔科技集团大中华区网络和第三方产品事业部虞颂峰介绍,戴尔科技的能力也得到了市场研究机构的认可,Forrester在 2024 年Q1 的《AI 基础设施解决方案》报告中将戴尔科技列入 AI 基础架构解决方案领导者。

传统风冷不行,液冷势在必行

AI负载的高电耗可能让原来数据中心设计的电力不够用,甚至外围供电不足,迫使人们需要寻找更多能源,比如引入清洁能源、核能等。而另一个后果就是不得不关注绿色数据中心的建设,关注机房内部致冷问题。

通常数据中心中部署有大量IT设备,如服务器、存储和交换机等,以及空调等附加设备,这些设备运行需要散发大量的热,必须及时带走,否则会因过高的温度会导致设备损坏,系统宕机。传统数据中心致冷方式是以风冷为主,老旧机架设计功率不超过10kw左右。然而,今天一台配置多GPU卡的AI服务器单台功率就可能突破10kw,传统风冷技术很难解决其散热问题,不得已人们开始选择液冷技术。

“为了满足 AI 的应用,实现可持续、低碳、节能和环保的绿色数据中心,从目前的技术手段来看,液冷是最佳的选择。”虞颂峰表示。

液冷解决方案的普及除了要解决机房温度过高或者局部热点问题这些内因之外,还有非常重要的一个驱动因素是国家政策。近几年国家在大力推动节能环保,一直在限制高能耗数据中心。比如,北京要求新建数据中心PUE值低于1.4,上海、深圳要求低于1.3。高PUE值意味着高能耗,特别是对于一些大型和超大型数据中心,其用电量大,降低运营成本和符合国产政策的要求双重因素驱动下,对液冷技术积极性很高。

各种利好之下,液冷市场增长很快。根据IDC发布的《中国半年度液冷服务器市场(2023上半年)跟踪》报告,2023上半年中国液冷服务器市场规模达到6.6亿美元,同比增长283.3%,预计2023年全年将达到15.1亿美元。IDC预计,2022-2027年,中国液冷服务器市场年复合增长率将达到54.7%,2027年市场规模将达到89亿美元。

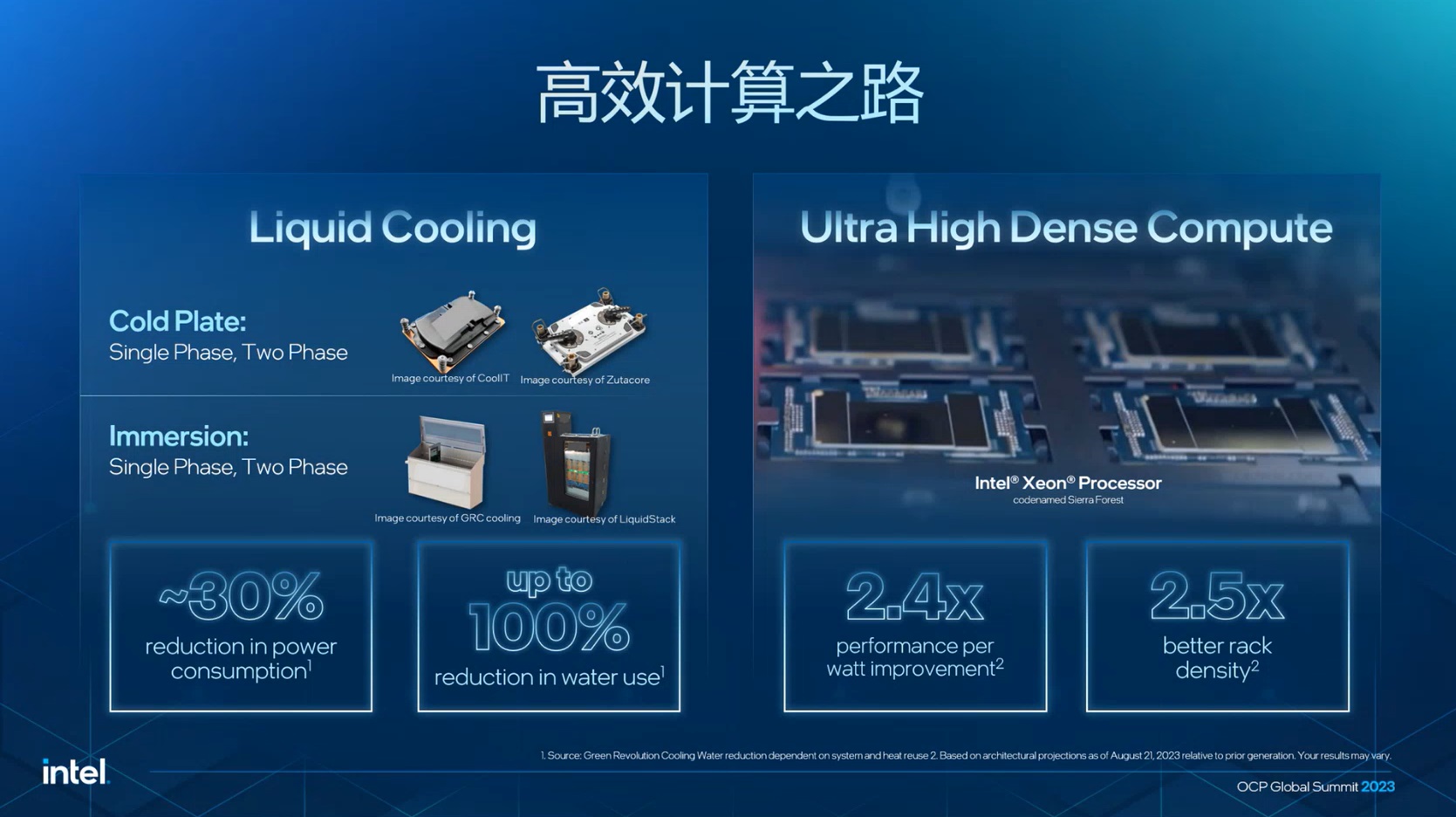

目前市场上主要有两类主流液冷技术。一类是冷板式液冷,液体不直接接触IT部件,通过液体在密闭的导管流经服务器内部的散热冷盘将热量带走。另一个是浸没式液冷,就是直接把整台服务器泡在特殊液体中,通过与液体进行热交换来带走热量。

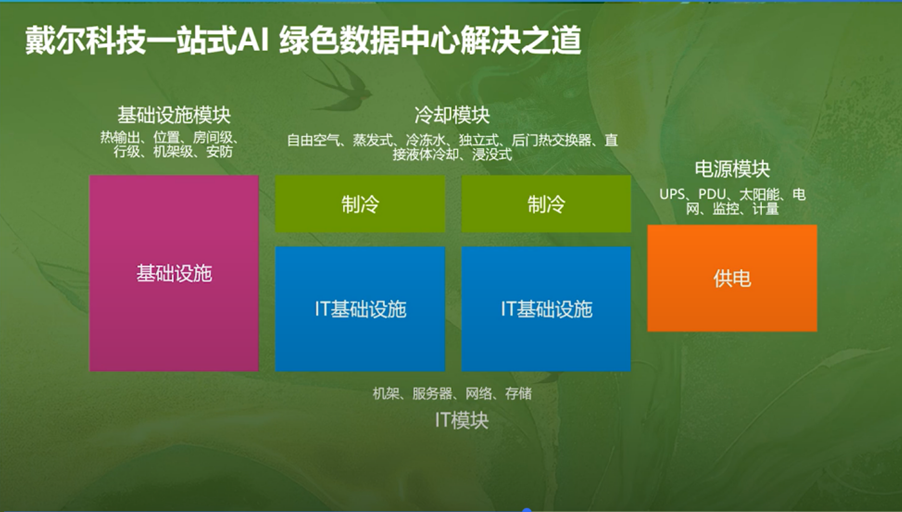

一些领先的服务器厂商已经推出了自己的液冷服务器产品。虞颂峰介绍,戴尔科技通过与合作伙伴合作提供三种液冷解决方案,既有冷板式液冷也有浸没式液冷,可以满足不同客户的需求。

DIY 冷板式液冷方案:方案采用戴尔科技的标准液冷服务器,配置 CoolIT 冷盘,加上第三方(绿色云图和维谛)的CDU 和液冷机柜,在客户现场组装完成整套液冷方案交付。

标准的整机柜交付冷板液冷方案:戴尔在工厂预安装液冷服务器和CoolIT的机柜、分水器,直接交付给客户。

浸没式液冷方案:采用的是经过戴尔科技验证的绿色云图的浸没式液冷解决方案,由绿色云图提供整合服务,适用于边缘应用、静音要求极高或者是极致PUE等应用场景。

高效节能需要整体优化设计

当然,要建成一个绿色数据中心光有液冷技术远远不够。绿色数据中心的建设应该从最开始的设计、规划就开始,一直到机房设备部署、冷却系统的部署,还要选择高效节能IT组件以及精细化的管理和运维等。

以系统的管理和监控为例,可以通过电源管理器实时监控并控制服务器的整体功耗和服务器的 CPU 负载情况实现风扇的动态调节,来有效降低数据中心的能耗。

F5公司解决方案顾问王志博透露,F5公司的产品落地场景中就有不少用来汇集各种IT设备运行状况,借助F5的产品采集数据,然后进行大数据分析和呈现,从而帮助管理者更好地管理这些设备,提高设备运营能效。

值得一提的是,并非只有新建数据中心才能谈绿色节能,对于现有的数据中心也可以通过改造来提高能效。比如,通过模块化的数据中心实现冷热通道的隔离,通过后门热交换提高热交换效率,通过优化传统数据中心最多可以实现PUE1.2 左右。

采用高能效的新一代产品也是一种有效的节能方法。英特尔中国可持续发展项目组负责人彭振飞介绍,采用英特尔最新的第五代至强可扩展处理器,通过选择电源优化模式就可以在30-40%工作负载时轻松实现110瓦的能耗降低。英特尔即将正式发布的至强6在能效上表现更为优秀,至强6 Sierra Forest首次采用纯能效核(E核)设计,可以带来2.4倍的能效提升,机架密度则可以提高2.7倍。这意味着在相同的空间里能提供更高的算力,并且是更高能效的算力。

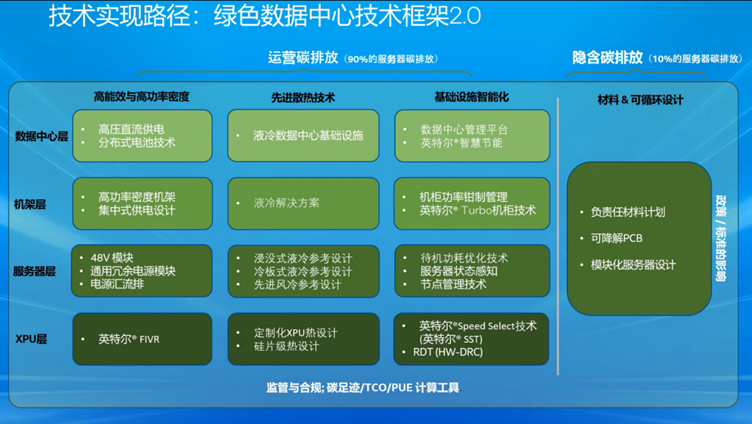

为了帮助企业构建绿色数据中心,英特尔还推出了绿色数据中心技术框架2.0,这是一个参考设计,它从XPU层、服务器层、机架层和数据中心层分别提出了合理实现节能减碳的技术路径,一共提出了13种让数据中心更绿色的技术能力和方案。

“这是一个框架,目的是希望通过高能效产品和技术的使用,通过液冷,通过更高能效的处理器等IT组件结合,实现高能效的计算,构建更绿色的数据中心。”彭振飞说。

结束语

当下在AI应用热潮的推动下,算力需求井喷。数据中心作为承载AI应用的关键,在满足算力需求的同时面临能效问题的挑战,这使得数据中心的绿色低碳和可持续发展成为刚需。

液冷技术在政策、技术与经济性三大因素的共同推动下成为绿色数据中心建设的重要技术之一,正在快速替代风冷技术发展成为市场主流。面对这个新兴市场,有着丰富的技术积淀和对产业了解的戴尔、英特尔等巨头的加入无疑会大大推动液冷技术的进步,加速绿色数据中心在中国市场的落地步伐,最终为我国数字经济的高质量发展提供更为强大的核心驱动力。

|