《麻省理工科技评论》曾将人脸识别技术评选为2017年的“十大突破性技术”。但,“万物有矛必有盾”。随着人脸识别技术跨入成熟应用期,各式各样的“人脸识别之矛”也在 2019 年频繁出现在公众视野之中。

现在,算法研究人员用一个面具、一张贴纸、一件衣服、甚至一个纹身,就能干扰机器的人脸识别。

近日,美国 AI 初创公司耐能(Kneron)的研究员,便成功利用特制的3D面具,通过包括微信支付、支付宝、铁路刷脸进站在内的人脸识别完成支付。对此,支付宝团队回应,此前试图联系这家企业获取详细信息,但是对方将该新闻及视频下架,没有提供更多信息。而微信方面称,目前已采用了多项技术,可以有效抵御视频、纸片、面具等攻击。两家均表示,如果出现刷脸支付导致盗刷可申请全额赔付。

2017 年入选 “十大突破性技术” 的“刷脸支付”

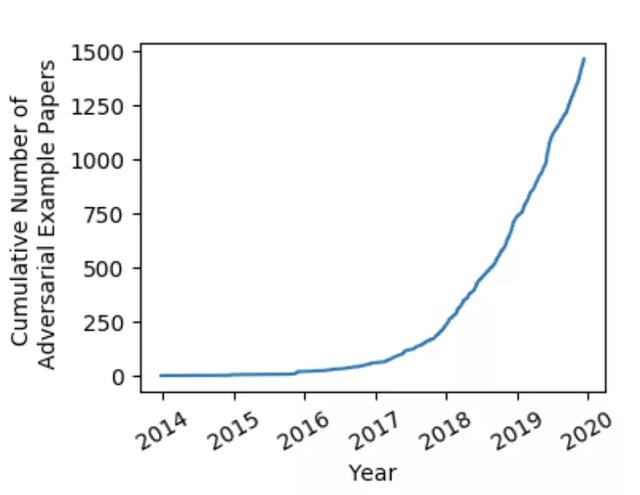

这些现象背后,计算机视觉技术赋予越来越多的机器以识别能力,其对应的颇具代表性的一类“矛”——对抗样本(adversarial example)——也在近两年呈现出热度急剧上升的趋势。

现有计算机视觉基本上基于深度学习(尤其是人脸识别技术),而对抗样本,正是通过给正常数据样本引入细微特殊噪声后、导致深度学习模型识别错误的样本,产生所谓的 “对抗” 效果。

在即将过去的 2019 年,诸多迹象都在指向以对抗样本研究为代表的 AI 安全研究正在成为一大热门技术话题。

加州伯克利计算机安全专业博士生 Nicholas Carlini 就给出了一项不完全统计,全球最大的预印本网站 arXiv 上,对抗样本相关的论文在 2019 年间数量暴涨。

无独有偶,同样在 2019 年,中国人脸识别第一案爆发、全球人脸识别标准启动制定、多地爆发人脸识别抗议活动,人脸识别技术走向下一个发展阶段,与用户隐私问题相生相伴的,正是其安全性问题。

IEEE 于 12 月 10 日发布的 “2020 年 12 大技术趋势” 中,也将与对抗样本息息相关的“对抗机器学习”(Adversarial Machine Learning )列入其中,显示这个方向将在 2020 年展现颠覆市场的潜力。

IEEE 认为:“机器学习算法通常假定在训练和评估模型期间,不会遭遇外部的恶意操作。换句话说,大多数机器学习模型都没有充分考虑被攻击或者被操纵的可能性。但是,越来越多的安全研究人员已经证明,即使没有关于目标模型参数的完整信息,恶意的输入(例如对抗样本)也可以操纵机器学习算法的输出效果。

但随着越来越多的机器学习算法被整合到各种各样的现实系统中,对这些算法的恶意攻击频率将会上升。如此看来,针对对抗机器学习的安全性研究和探索侦测机器学习系统是否被恶意操纵的方法,将变得至关重要”。以计算机视觉首当其冲的一场 AI 攻防战,已燃起烽火。

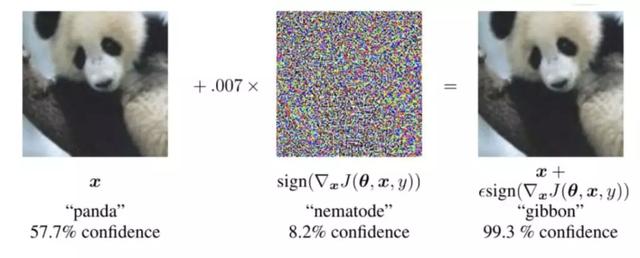

将图像稍加干扰像素之后,熊猫便被错误分类成长臂猿

计算机视觉的“阿喀琉斯之踵”:微小扰动,识别概率就可大幅下降

对抗样本这一概念于 2013 年由学者 Szegedy C 提出。

当时,由他所著的名为《Intriguing properties of neural networks》的研究论文,首次揭示了深度神经网络的一大弱点所在:其极易受到对抗性样本的影响,只需通过对输入样本进行细微改动,深度神经网络进行错误分类的概率就会大幅提升。

“对抗样本的出现,使得原本准确率较高的深度学习模型出现了严重的正确率下降的现象,其对于现有模型的攻击效果引起了很大的关注。对抗样本通过添加微小扰动的方式,大多在人眼看不见的情况下,取得欺骗模型的成绩,对于现有的深度模型提出了一定意义上的挑战,也对攻防两个方面提出了新的要求”,浙江大学计算机学院宋明黎教授说。

2013 年之后,Nguyen 等人提出,面对一些人类无法识别的样本,深度学习模型也可以将其以高置信度进行分类。这意味着深度学习模型具有极大脆弱性,在理论上存在凭借垃圾样本通过识别分类系统的可能性。

而自 Szegedy C 提出对抗样本以后,“GAN 之父” Ian GoodFellow 在 2014 年解释了对抗样本的基本原理,即高维网络的线性状态。自那之后,围绕于生成对抗样本的迭代算法开始涌现,出现了各类流派。

宋明黎教授表示,对抗样本的现有研究思路,总体上可以分成全像素添加扰动和部分像素添加扰动两类,每一类中又可以分成目标是否定向、是否黑盒(在无法获取模型内部的所有信息和参数基础上的攻击)和是否肉眼可见。

“全像素添加扰动是指在原图像的所有像素点均加上合适的扰动,部分像素扰动只对原图像的部分像素进行修改。全像素扰动注重对抗性和适应性的提高,即,是否能产生更高的误分类率和是否具有可迁移性等特性;部分像素扰动更加注重选择的像素数量、代价和对抗性之间的关系。基此分类,可突出各自不同的期望目标,即寻求质量提高还是寻求扰动微小”。

例如,在更高的误分类率上,2018 年多伦多大学教授 Parham Aarabi 和研究生 Avishek Bose 发明的一种算法中,通过对图像进行光转换,动态地破坏面部识别系统,人脸识别系统中被检测到的人脸的比例就能降低到 0.5%。

人脸已经不被检测到

研究上用对抗样本调戏 AI 分类器、或者干扰机器进行人脸识别,我们尚可一笑而过嘲笑机器之愚蠢。但是,如果部署到公共空间的机器,被对抗样本所迷惑,将你错误识别成了老赖、潜逃犯,或者是一辆自动驾驶汽车无法正确识别路标,问题就大了。

伯克利、OpenAI 以及宾大联合发表的论文《Adversarial Attacks on Neural Network Policies》,内华达大学《Vulnerability of Deep Reinforcement Learning to Policy Induction Attacks》等多项研究也表明,广为采用的强化学习算法(比如,DQN、TRPO 以及 A3C)都经不起对抗样本的捉弄。

事实上,对抗样本的研究,本质上属于网络信息安全的范畴,是为了确保视觉算法在现实应用中能够有更高的安全性。因此,针对对抗样本的研究,具有很高的产业价值。

已有国内厂商攻破手机人脸识别+特斯拉自动驾驶

在 2019 年,国内两个团队在今年分别实现了对手机和汽车的对抗攻击(adversarial attack,基于对抗样本的攻击)。

2019 年 4 月初,专注于安全技术的腾讯科恩实验室公布了一项在特斯拉 Model S 上进行的安全性研究,并发布报告指出了三个缺陷,其中就包括雨刷、车道的两项视觉识别,而两者正是基于对抗攻击。

在实验中,团队将特斯拉停在一个室内环境中,在车辆前播放特定的干扰画面,使车辆得出了下雨的错误判断,导致雨刷自动启动。实验室表示,这是利用 AI 对抗样本生成技术生成特定图像并实现了对汽车的干扰,而在随机生成的画面中则不会出现这种情况。

车道的实验则更为惊险。在科恩实验室发布的视频演示中,道路特定位置上摆放三张小纸片,一般情况下人类驾驶员都难以轻易察觉纸片的存在,然而特斯拉在 Autopilot 驾驶模式下行驶到该位置时,突然作出转向决策进入到隔壁的逆行车道。

腾讯团队在报告中指出,在天气识别和车道识别上,特斯拉都是基于视觉识别技术感知环境,再作出决策。团队研究了特斯拉车道识别过程,在实际的道路上摆放了数个纸片,实现了物理上的对抗图像攻击,让汽车产生了错误的车道判断。

而清华背景的 AI 安全初创公司 RealAI,则在今年成功攻破商用手机的人脸识别,这也是迄今唯一通过对抗样本攻击商用手机人脸识别成功的案例。这家公司正在打造安全、可靠、可解释的第三代人工智能,提供工业检测、预测性维护、金融风控、人工智能系统安全评测与防护等服务。

但需要指出,尚未出现成规模的攻破人脸识别系统的案例。

对此,宋明黎教授解释道,对抗样本可迁移性的局限,导致其还无法做到大规模的攻击。对抗样本的迁移性,即基于一个深度模型构建的对抗样本攻击其他机器学习模型的能力,但现在的对抗样本仍未具备很好的迁移性。

“应用在现实世界的对抗样本必须是黑盒攻击,不了解原模型的内部结构,这类对抗样本的可迁移性并没有达到可以普遍应用的效果”,他说。

AI 进入产业深水区,安全问题将成重中之重

随着人工智能技术继续“赋能百业”、与各行各业的核心业务场景结合得更加紧密,新兴技术带来新的产业攻防场景,将是一个重要话题。

现有的大量 AI 公司都集中在应用开发领域,而专注于 AI 安全研究的初创公司仍显少见。

根据 Technavio 最新市场研究报告预测,全球基于人工智能的网络安全市场将在 2018-2022 年期间实现超 29% 的复合年增长。作为 AI + 安全赛道玩家之一,RealAI 团队认为,人工智能安全未来将会发展到和网络安全同等的规模。

在一场业内峰会上,腾讯科恩实验室总监吕一平接受 DeepTech 采访时也表示:“AI 现在在各行各业应用场景较多,未来会出现新的对 AI 算法对抗的研究,这可能也会成为一个安全研究的新方向”。

据他介绍,在 AI 安全的方向上,科恩实验室现正在从两个角度开展研究:

1、AI 算法本身的安全。比如关于智能汽车视觉、AI 的对抗,不管是车道线的变换,研究算法,还是制造 AI、视觉的对抗样本,最后都干扰了汽车的驾驶决策。

2、怎么样用 AI 的能力来辅助安全研究?安全研究仍是一个以人为主的领域,靠人的经验和突发奇想的创造力得以推进。

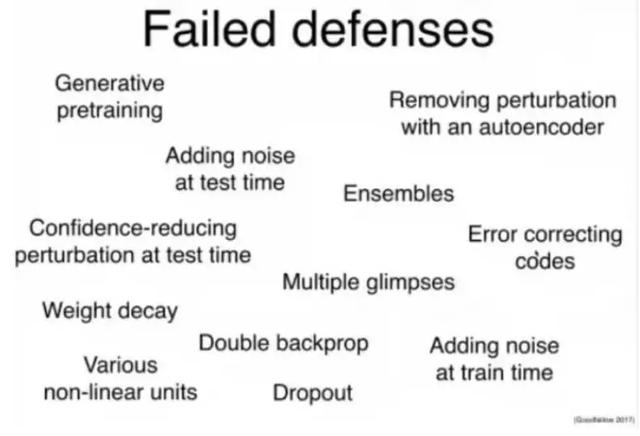

目前还没有强有力的防御对抗样本的工具出现

具体到防御对抗样本上,这同样是一个全新领域,尽管目前还没有一招吃遍天下的防御手段,但其中不乏一些重要的进展。

宋明黎介绍道,例如在黑盒攻击和可迁移性上,MI-FGSM 算法有比较好的效果,其在借鉴了 I-FGSM 和 ILCM 两种算法以后提出的。“MI-FGSM 在 CAAD 攻防赛中也使用了该模型,取得了第一的成绩,“但整体而言,防御对抗样本还属于需要突破的阶段,在各大方面也有比较可观的应用价值”,他说。

当然,AI 技术的安全问题并不止对抗样本一个方面,但正如 Ian GoodFellow 在一篇对抗样本的研究文章中所说:“我们认为对抗样本是安全方面非常好的议题,因为它代表了 AI 安全里的一种具体问题,可以在较短期里去关注和解决,而且这个问题的难度也是足够的,需要进行一些重要的研究工作”。

附:迄今出现的一些有趣的对抗样本“时尚单品”

1、方形贴纸:

一种特别的贴纸交给左边的人后,AI 瞬间就检测不了左边的人。

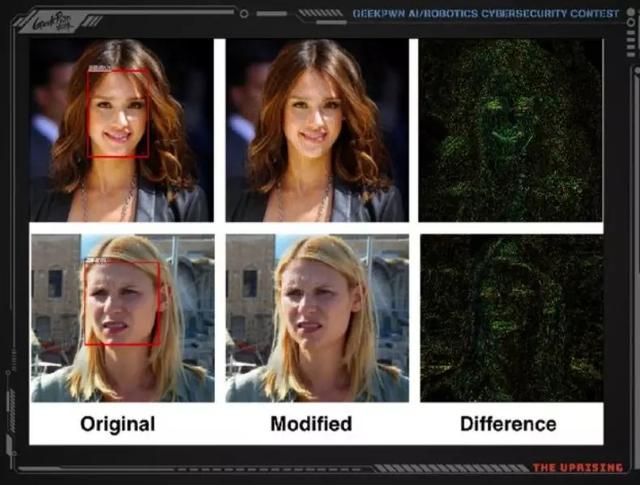

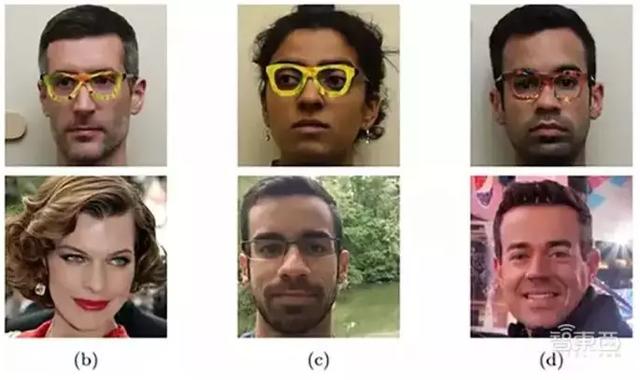

2、眼镜贴片

一种眼镜贴片能使人脸识别系统将你错认为其他人

图丨上为真人,下为系统错误识别出的人

3、路标

将一种贴纸应用在真实的 “停止” 标志上,YOLO 和 Faster-RCNN 两种算法都无法在正常距离中识别“停止”。

图丨 Faster R-CNN,为 YOLO 生成的真实对抗样本对 Faster R-CNN 做黑盒迁移测试

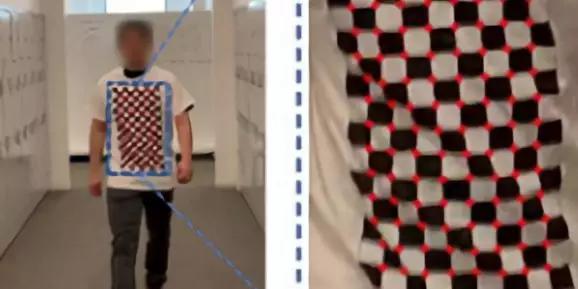

4、T-shirt

这件“对抗样本” T 恤可以保证即使印刷图像随着穿着者的姿势变化发生变形,也能干扰人脸检测器。

5、帽子

在一顶帽子上贴上特殊的图案之后,ArcFace 算法无法检测到人脸。

|